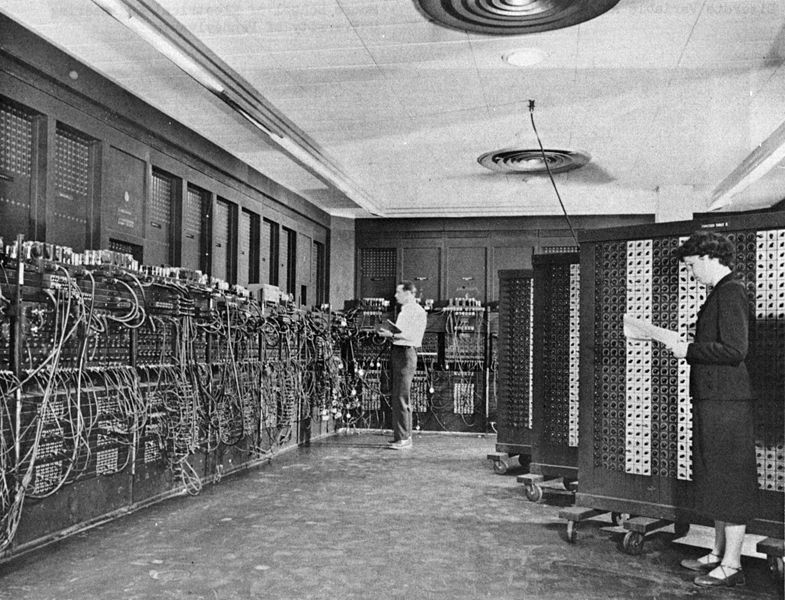

Même si tous les éléments du puzzle sont présents en 1945, il n'est pas encore possible, à cette date, de parler d'ordinateur. En effet, tous les calculateurs de l'époque sont fondamentalement conçus sur le même modèle que les premières machines à calculer, des bouliers très améliorés. Même l'ENIAC (1946), longtemps qualifié à tort de premier ordinateur[11], avec son électronique révolutionnaire capable de battre à 200 000 pulsations par seconde, nécessitait une saisie préalable et des données et des étapes de calcul à effectuer. À cette époque on ne programmait pas encore : on configurait la machine en vue de tel ou tel calcul (p.ex. sur la photo suivante). L'électronique est bien un ingrédient de l'informatique moderne, le plus visible, mais certainement pas le plus déterminant. Pourtant de nombreux acteurs et observateurs parlent de « cerveaux géants »[12] pour désigner ces immenses calculateurs (moins puissants toutefois que les puces contrôlant aujourd'hui notre électroménager).

La période qui va de la fin des années 1930 aux années 1950, était un temps de bouillonnement intellectuel pour comprendre le comportement, la communication et l'information. C'est à cette époque que se développent ou se répandent le béhaviorisme, la cybernétique et le structuralisme.

La convergence des deux ingrédients de l'ordinateur (conceptuel et technologique) se fait, semble-t-il, par le plus grand des hasards, quand en août 1944, pendant la guerre, un responsable de la supervision militaire de l'ENIAC croise sur un quai de gare John von Neumann (1903-1957), probablement l'un des plus grands logiciens du 20e siècle (et aussi l'un des plus grands mathématiciens, l'un des plus grands économistes et un très grand physicien) [Breton, pp. 75-77]. Il lui demande son avis sur l'ENIAC (qui n'était pas encore opérationnel) et des propositions pour construire son successeur. À la suite de nombreux échanges, von Neumann publiera un pré-rapport qui définit l'architecture, dite « architecture de von Neumann », du successeur de l'ENIAC, l'EDVAC, et, de fait, de (quasi) tous les ordinateurs qui suivront, jusqu'au début du 21e siècle : First Draft of a Report on the EDVAC (1945).

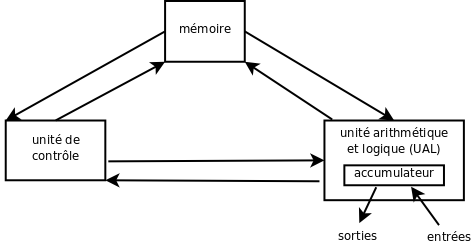

La conception en est résolument nouvelle : le calculateur devient une machine arithmétique, logique et, plus généralement, de traitement de l'information, il est doté d'une vaste mémoire permettant de stocker et des données et des programmes enregistrés, qui ne sont désormais plus fondamentalement différents des autres données (idée issue des travaux sur les machines de Turing), et, surtout, il est piloté par une unité de commande interne (idée de von Neumann) [Breton, pp. 80-82]. L'ordinateur devient donc entièrement automatique, première révolution.

Deuxième révolution, qui justifiera une terminologie nouvelle : il ne s'agit plus désormais de calculer, mais de traiter de l'information binaire. Précisément, les ordinateurs seront des machines universelles, au sens mathématique du terme, c'est à dire capables d'implémenter tout algorithme, en principe (c'est à dire à condition de disposer de ressources suffisantes). Le mot « informatique » sera créé en 1962 par Philippe Dreyfus pour désigner la nouvelle discipline, scientifique et technique : c'est, littéralement, l'automatique (-matique) de l'information (infor-). C'est l'occasion de préciser un peu ce dernier mot, « information ». Il signifia d'abord façonnage (mise en forme) puis instruction (instruire une personne ou instruire une affaire judiciaire) pour désigner finalement un simple fait rapporté (par un journaliste, par exemple). Le sens technique apparaît en 1927 (Ralph Hartley, 1888-1970) [Breton, p. 37]. Il sera précisé peu à peu et aboutira en 1948 à la Théorie mathématique de l'information de Claude Shannon (1916-2001), qui l'établira sur une base mathématique solide. Aujourd'hui ce sens précis et le sens courant continuent à coexister, ce qui ne clarifie pas toujours les débats… Quand on oppose l'information à la connaissance ou à la donnée, de quel sens s'agit-il ?

En 1955, pour commercialiser son premier ordinateur de grande diffusion (les précédents étaient destinés à l'armée ou à la recherche), la société IBM France fait appel au philologue Jacques Perret (1906-1992) pour suggérer un nouveau mot, le mot « calculateur » ne répondant plus à la diversité des tâches désormais possibles. Celui-ci propose de renouveler le terme « ordinateur », qui à l'origine désignait Dieu mettant de l'ordre dans l'Univers — pouvait-on alors viser plus bas que Dieu ? En anglais, le passage de calculator à computer est beaucoup moins impliquant. Avec le mot « ordinateur » la machine passe au second plan derrière l'information et son traitement : l'ordinateur c'est le pouvoir qui vient avec le savoir. Souvenons-nous de la maxime d'Auguste Comte : « Savoir pour prévoir, afin de pouvoir », souvent résumée en : « savoir, c'est pouvoir ». Rappelons-nous que Turing comme von Neumann visaient un véritable cerveau artificiel, modèle réduit du cerveau humain. Cette image, malgré la banalisation des ordinateurs, est encore vivante aujourd'hui.