Table des matières

L'objet conceptuel central de l'informatique est l'information. De façon prépondérante cet objet est issu de la notion d' « architecture de von Neumann ». Il subit également l'influence, moindre aujourd'hui, de la « théorie de l'information » de Shannon. Cet objet prend également place dans le contexte plus large des théories du calcul, qui dépassent le champs de ce cours.

Définition simplifiée : ordinateur : machine universelle automatique du traitement de l’information, obéissant à des programmes constitués de suites d’opérations arithmétiques, logiques et de commande.

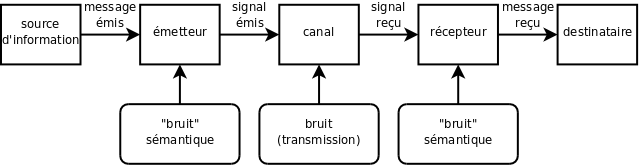

La théorie de Shannon est la première grande théorie systématique (et même mathématique) de la communication. Elle définit celle-ci comme un transfert d'information entre un émetteur et un récepteur à travers un canal de communication. Cette information ne peut être véhiculée que sous la forme d'un code commun aux deux parties. Les défauts de transmission de l'information par le canal sont appelés : bruit.

Deux grands types de signaux : analogique : signal continu qui varie comme l'information qu'il représente (comme une analogie), numérique : signal discret (ou discontinu, ou nominal) qui code l'information sous forme symbolique.